داده کاوی چیست؟

مقدمه

داده کـاوی در حقیقت کشف ساختارهای جالب توجه،غیرمنتظره و با ارزش از روی مجموعهء گسترهای از دادهها است و فعالیتی است که اساسا با آمار و تحلیل موشکافانه داده منطبق است.همچنین فعالیتی است که با سایر رشتهها مشخصا مانند تئوری بانک اطلاعاتی،یادگیری مـاشین، الگوشناسی و هوش مصنوعی در تداخل است.هر یک از این رشتهها رنگ و بوی خاصی به کار داده کاوی میبخشد و هریک از آنها احساس تعلقی منطقی به قلمروی نوظهور داده کاوی دارند که ممکن است بروز تنشهائی را موجب شود.خوشبختانه این تنشها چـنانچه پژوهـشگران رشتههای مختلف بر دیدگاهها و نظرات یکدیگر ارج نهند ثمربخش خواهد بود.

علت اینکه این مقوله بجای دو دهه گذشته اخیرا مطرح شده است این واقعیت است که فنآوری امروزی به انباشتگی مجموعههای بسیار حـجیمی از دادهـها منجر شده است. در این رابطه نمونههائی را ارائه کرده است.این مجموعه دادهها حاوی میلیونها و بلکه میلیاردها قلم سوابق ثبت شده است.این دادهها نوعا به این منظور استخراج میشون تا پاسخگوی سؤالاتی باشند که صـرفا بـرای آنها جمعآوری و ذخیره شدهاند.

امروزه ذخیرهسازی اطلاعات بسیار ارزان است.طوری که تودههای گستردهای از دادههای گوناگون در همهجا پراکنده است.آشکار است و یا حد اقل طرفداران داده کاوی این نوید را میدهند که کوههای عظیم دادهها در دل خـود اطـلاعاتی دارنـد که میتواند ارزشمند باشد.برای بهرهبرداری از ایـن مـخازن عـظیم تنها زحمتی که باقی میماند اقدام به بیرون کشیدن آن اطلاعات ارزشمند است.بنابراین اصطلاح"داده کاوی"برای گردآوری ناهمگن ابزارها بمنظور استخراج اطلاعات بالقوه ارزشمند از درون سـلسله کـوههای عـظیم دادهها به کار میرود.

اهداف داده کاوی

در اینجا تمایز بین دو نوع روش داده کـاوی مـفید بنظر میرسد.روش اول مدلسازی دادهها است.در این روش هدف ارائه یک جمعبندی کلی از دادههای مفروض است که ویژگیهای عمدهء آنرا بدست دهد.بنابراین بـرای مـثال مـیتوانیم شبکهای را مبتنی بر دیدگاه بیضی،مدل رگرسیونی،شبکه عصبی،مدل درختی و غیره ایجاد کـنیم.آشکار است که هدف در اعمال این روش با هدف مدلسازی استاندارد آماری بسیار شباهت دارد.به خصوص احتمال دارد که الگوریتمهای استاندارد خیلی کـند بـاشد و مـدلسازی استاندارد آماری نیز به مدلهای بیش از حد پیچیده منجر شود زیرا حـتی ویـژگیهای جزئی هم کاملا معنیدار خواهند بود.در ادامهء بحث این نکات را بررسی خواهیم کرد. احتمالا واقعیت دارد که بگوئیم بیشتر فـعالیتهای آمـاری بـه نحوی از انحاء با استنباطدر ارتباط است.بدین معنی که هدف از بهرهگیری از دادههای موجود ارائه فـرضیات در خـصوص جـامعه مولد این دادهها،ارزش مشاهدات آینده و سایر مقولات است.بیشتر فعالیتهای داده کاوی دارای همین ماهیت است.در چنین شـرایطی بـه دادهـهای موجود به عنوان نمونهای از جامعهای منتخب با ارزشهای ویژه نگریسته میشود.ولی در بسیاری از شرائط داده کاوی کـلیه دادهـهای ممکن در دسترس است و هدف این نیست که استنباطی که صورت میگیرد از حدود این دادهـها فـراتر رود بـلکه آنچه مطلوب است "توصیف"دادهها است. در این حالت استفاده از روشهای استنباط مانند آزمونهای فرض برای تعیین ایـنکه اصولا کـدام یک از ویژگیهای مدل توصیفکننده باید مد نظر قرار گیرد،نامربوط به نظر میرسد.بنابراین باید از سـایر مـعیارها بـهرهگیری شود.

نوع دوم روش داده کاوی الگویابی است.در این روش هدف ساختن مدلی توصیفی که کاملا جامع و فراگیر باشد نـیست بـلکه کشف ویژگیها،بیقاعدهگیها یا صرفا الگوهای غیرمعمول یا توجهبرانگیز در دادهها مد نظر است.لازم بـه ذکـر اسـت که آمارشناسان در اجرای فعالیتها توجه اصلی خود را صرفا به الگویابی معطوف نکردهاند چونکه هدف (استنباطی)عمدتا ارزیـابی"واقعیت"یک الگـو بـمحض کشف آن بوده است.هدف در داده کاوی در درجهء اول یافتن الگوها است و نوعا باید ثبت واقـعیت،مطلوبیت و یـا ارزش آن الگو بر عهده مالک بانک اطلاعات یا کارشناس ذیربط قرار گیرد.بنابراین کاوندهء دادهها ممکن است بـه دنـبال یافتن خوشههائی از مردمی باشد که مبتلا به بیماریهای خاص هستند درحالیکه متخصصین بـیماریهای واگـیردار خوشه موردنظر را ارزیابی کنند تا ببینند که صـرفا بـرآمده از تـغییرات تصادفی است یا خیر.البته بیشتر مسائل در فـضاهای دادههای بـیش از دو متغیر(همراه با نقطههای زیاد)بروز میکند که به همین علت،باید از راهکارهای تحلیلی رسمی بـهرهگیری کنیم.

تصور مـن این است که بیشتر خـوانندگان ایـن مقاله آشـنائی گـستردهای بـا مدلسازی دارند و به بحث من که بـیشتر حـول محور الگویابی دور میزند عنایت خواهند کرد.

ما همواره الگوها را در مجموعه دادههای گسترده خـواهیم یـافت.در درجه اول این طبیعت قوهء درک انسان است کـه سعی میکند تصاویر یـا سـایر محرکهها را برحسب اشیاء شناخته شده تـفسیر کـند.برای مثال همین است که ما در ابرها صورتها و د الگوها ستارهها کمانها و خرچنگها را میبینیم و انواع شـکلهای مـختلف را در لکههای جوهر مشاهده میکنیم.

نکته این است کـه مـا سـاختاری را که در دادهها مـشاهده مـیکنیم با مجموعهء وسیعی از الگـوهای شـناخته شده(اشیاء)تطبیق میدهیم تا الگوی مطلوب خود را بیابیم.چنانچه از پیش محدودیتی برای الگوی موردنظر خود قـائل نـشویم شناخت یک ساختار به عنوان یک الگـو خـیلی دشوار نـخواهد بود.

دوم ایـنکه پدیـدار شدن برخی از الگوها در مـجموعه دادهها غیر قابل اجتناب است.با فرض اینکه عناصر مجموعهای از دادهها بتوانند 001 ارزش احتمالی را احراز کنند و 101 موضوع هـم مـحاسبه شده باشد مطمئنا حد اقل دو تـا از آنـها از ارزش یـکسانی برخوردار خـواهند بـود.چنانچه 10001 موضوع را برحسب ارزشـهائی کـه در مورد یک متغیر احراز میکند مرتب کنیم بدین ترتیب این اطمینان حاصل میشود که میتوانیم 101 موضوع را بـیابیم کـه در مـورد هر متغیر دیگر رتبهای صعودی یا نـزولی داشـته باشند.

سوم ایـنکه چـنانچه مـجموعهای از دادهـهای بحد کافی بزرگ در اختیار داشته باشیم در نتیجه احتمال وجود هر الگوی کوچکی هم بزرگ خواهد بود.در مقابل اولین حالتی که در فوق ذکر شد ما الگوهای(موضوعات)شناخته شده را با مـجموعهء وسیعی از رخدادهای بالقوه موجود در دادهها تطبیق میدهیم.احتمال اینکه هریک از سوابق ثبت شده الگوئی خاص را نشان دهد فقط یک در یک میلیون است اما چنانچه 100 میلیون مورد از سوابق ثبت شده وجود داشته باشد نـباید از مـشاهدهء الگوی موردنظر خیلی تعجب کنیم.

چنانچه الگوها خیلی محتمل باشند و یا حتی غیرقابل اجتناب باشند چگونهمیتوانیم معین کنیم که الگوی مشاهده شده نمایانگر چیزی واقعی است؟و یا چیزی است که شناختن آن ارزش دارد؟البته هر دو سـوال بـاهم تفاوت دارند ولی در مقولهء داده کاوی دارای یک پاسخ هستند:باید به کارشناس ذیربط رجوع شود.وظیف(کاوندهء دادهها یافتن الگوهاست تا آنها را به نظر فردی برساند که اهمیت ذاتـی و بـالقوهء دادهها و الگوها را تشخیص میدهد.من در فـعالیتهای مـربوط به خود دریافتهام که چنین کارشناسان توانائی اغلب میتوانند تحلیلهای گذشته نگرانه را برای"الگو"ارائه کنند.

به علاوه بنظرم میرشد که این امر را میتوان به عنوان نماگر"واقعیت"تلقی کرد و مـطمئنا مـیتوان آنرا نیز به عـنوان شـاخص اطمینانی در نظر گرفت که فرد باید در مورد الگوی کشف شده قائل شود. اگر شخص نتواند توجیهی را برای چگونگی بروز ساختار الگو تصور کند باید نسبت به مبنا قرار دادن ساختار مذکور برای تصمیمات و برنامههای آیـنده تـردید کند.

روشهای داده کاوی الگوهای زیادی را بدست میدهد.برای مثال از طریق تحلیل سبد بازار میتوان هزاران مورد از گروههائی از کالاها را که خریداران در سوپرمارکتها مایل بخرید هستند مورد شناسائی قرار داد.ما ابزاری را برای یافتن خوشههای محلی در دادهها تـهیه کـردهایم که مـیتواند تعداد زیادی از این خوشهها را بیابد.درحالیکه اصولا میتوان این تعداد از خوشهها را به کارشناس ذیربط(برای مثال مدیر سوپر مارکت)انتقال داد ولی این امـر در عمل امکانپذیر نبوده است.در درجهء اول باید روشی را برای انتخاب یکی از راهـکارها بـرگزید تـا از جهتی متضمن بیشترین نوید برای تحقق هدف باشد.انتخاب برمبنای آزمون معنیدار بودن آماری مؤثر نخواهد بود.چنانچه تعداد بسیاری از الگـوهای بـالقوه مد نظر قرار گیرند،تفسیر مبتنی بر احتمال شبههآمیز خواهد بود و چنانچه میزان خطائی کـلی مـبتنی بـر تجربه اتخاذ شود این احتمال وجود دارد که هیچ الگوئی پذیرفت نشود.البته پاسخ کافی در این مـورد وجود ندارد.راهکار کاملا پذیرفته شده استفاده از تابع نمره(امتیاز)یعنی معیاری از توجهبرانگیز بودن، غیرمنتظره بودن یا غـیرمعمول بودن الگوها است و نـیز نـادیده گرفته الگوهائی است کهبالاترین نمره را احراز میکنند.البته برخی از اوقات تابع نمره(امتیاز)یک معیار شناخته شدهء آماری است ولی فاقد تفسیر احتمالاتی است.

کیفیت دادهها

دادههای بیکیفیت همواره نتایج بیکیفیت بدست میدهد.اما مشکل،زمانی حادتر میشود که مجموعه دادهها وسیع باشد.همانطور کـه در بخش 5 خاطر نشان شده است چنانچه مجموعهء دادهها گسترده باشد حاکی از این معنی است که فرد لزوما از آن دور میافتد به طوریکه چیزهای زیادی وجود دارد که در داخل مجموعه تداوم مییابند و ممکن است به طـرق مـختلف مجموعه به خطا رود و فرد از این موارد بیاطلاع باشد.

به علاوه مجموعه دادههای بزرگ با احتمال بیشتری نسبت به مجموعه دادههای کوچک دچار خطا میشوند.در حقیقت چنانچه مجموعه دادههای ظاهرا شفاف در اختیار فرد قـرار گـیرد،این سؤال به درستی مطرح میشود که آیا این مجموعه را به طریقی شفاف کردهاند؟آیا مشاهدات ناقص حذف شدهاند یا ارزشهای گم شده جانهی شدهاند؟آیا عوامل بیرونی حذف شدهاند؟این موارد و سایر روشهای شـفافسازی دادهها مـیتواند در نتایج تأثیر بگذارد و این امر نیز اهمیت دارد که بدانیم آیا دادهها واقعا معرف آن چیزی هستند که باید باشند.

حتی مجموعه دادههائی که فرد امیدوار است دقیق باشد ممکن است پر از خطا باشد.در تـحلیل مـجموعهای از دادهـهی مربوط به شرح بازپرداخت وامـهای بـانکی، متوجه شـدیم که ارقام کوچک پرداخت شنده(مثال 1 P یا 2 P )به این معنی بود که مشتریان به عنوان"بدهکار بدحساب"طبقهبندی شده بودند،که ارزشهائی منفی از نظر مبلغ بدهی تـلقی مـیشد،و هـمچنین وامهای دوازده ماهه که پس از 42 ماه هنوز باز پرداخت نـشده بـودند(که از نظر فنی برطبق مقررات بانکی غیرمممکن است)و ترازهای معوقه به صفر رسیده بودند و سپس مجددا مثبت شده بودند و نیز تـرازهائی کـه هـمیشه صفر بودند و تعداد ماههای پسافتاده هم برحسب بیش از یک رقم مـنفرد در یک ماه درحال افزایش بود.و اینها فقط مواردی بودند که ما به آنها پی بردیم.تجاربی که در مورد بانکها داریم نشان مـیدهد کـه ایـن موارد اصلا غیرمعمول نیست بلکه روندی قابل انتظار است.کیفیت دادهها مسئلهای اسـاسی در داده کـاوی است نه فقط به این خاطر که دادههای تحریف شده بمعنی نتایج تحریف شده تلقی میشود بـلکه بـه ایـن علت هم که بسیاری از الگوهای"توجه برانگیز"یا"غیرمعمول"کشف شده ممکن است مستقیما منتج از دادههای معیوب باشند.

من بـا نـمونههای عـینی روبرو شدهام که همبستگیهای زیاد حاصل از دادههای گمشده بوده است و الگوها بواسطهء روشی که گـروهبندی شـده بـودند تحمیل شده است البته نمونههای دیگری هم وجود دارد.بدون اینکه از بسیاری از الگوهای توجهبرانگیز ذکری به مـیان آورم مـن و افراد گروهم الگوهائی را کشف کردهایم که ساخته روشهای اندازهگیری هستند.در حقیقت ما الگوهای بـسیار زیـادی را یـافتهایم که قابل انتساب به مسائل مرتبط با دادهها هستند.در این ارتباط نظر من این اسـت کـه ممکن است اکثریت الگوهای غیرمنتظره را به توان به همین علت منتسب نمود که ایـن امـر بـرای آینده داده کاوی به عنوان یک مقولهء ویژه حاوی پیامدهای آشکار خواهد بود.

تاکنون بحث کیفیت دادهها حـول مـحور سوابق فردی دور زده است.شاید مسائل حاصل از اریب انتخاب به این خاطر که غافلگیرکننده هـستند بـسیار حـاد باشند.چه سوابق جامعی از روی بانک اطلاعاتی مفقود شده است،آیا این سوابق در سراسر جامعه به طور متفاوت مفقود شـده اسـت،آیا سـوابق منتخب به این علت درج شدهاند که دستیابی به آنها آسان بوده است؟و سـایر پرسـشهائی که مطرح است.آمار مربوط به حوادث در جادهها نمونهء مطلوبی را از وجود خطرات بدست میدهد.معمولا حوادث حادتری که منجر بـه تـلفات جانی میشود با دقت زیادی ثبت میشود اما حوادثی که شدت آن کمتر اسـت مـانند مواردی که منجر به صدمات جزئی مـیشود یـا هـیچ صدمهای را ببار نمیآورد چندان دقیق ثبت نـمیشود.در حـقیقت نسبت بالائی اساسا ثبت نمیشود. این امر موجب انحراف در برداشتها میشود که منتج بـه نـتیجهگیریهای نادرست میشود. در بسیاری از موارد بدلیل مـشکل ارزیـابی دادهها(برای مـثال چـنانچه تـوزیع دادهها از طریق ماشینهای زیادی انجام گـیرد)و ایـن واقعیت که دادهها ممکن است پویا باشد فعالیتها ممکن است به طور مـغشوش انـجام شود.بنابراین ممکن است لازم شود کـه تحلیل موردنظر برمبنای زمان واقـعی صـورت گیرد.

الگوریتمها داده کاوی

مجموعه دادههای گسترده به این مـعنی اسـت که فرد نمیتواند دادههای موردنظر را شناسائی کند.تحقیقات لازم باید از طریق برنامههای پیچیدهء کامپیوتری بـه عـنوان واسطه صورت گیرد.از آنجائیکه این بـرنامهها نـیروی لازم را فـراهم میآورند بدون آنـها اصـولا نمیتوانیم پیش برویم.

البته این برنامهها حـاوی ایـن معنی هم هستند که ما ممکن است دچار قصور در توجه به موردی شویم که مـا را از پیـشروی باز دارد. نظر به اینکه این برنامهها در مـورد مـجموعههای وسیعی از دادهـها اعـمال مـیشود باید از سرعت لازم برخوردار باشند.اعمال روشـهای متوالی و انطباقی ضروری است و یک راهکار ساده ولی نسبتا بهینه باید به روشی که از نظر تـئوری بـرتر است ولی مستلزم صرف زمان بسیار طولانی اسـت تـرجیح داده شـود.برای مـثال مـا دریافتهایم که در بـسیاری از مـسائل رگرسیونی خطی دارای مزیتهای معنیداری نسبت به رگرسیون لجستیکی است هرچند که رگرسیون لجستیکی ممکن است مطلوبتر بـه نـظر رسد.

در مـقابل تأکیدی که بر استفاده از مدلها در آمار وجـود دارد نـقش بـرنامههای کـلیدی منجر بـه تـأکید بیشتر بر الگوریتمها در کار داده کاوی شده است.ایده این است که فرد الگوریتم را به این منظور در مورد دادهها به کار میبرد که از چگونگی عملکرد و خصوصیاتی که احراز مـیکند اطلاع حاصل کند بدون اینکه به مدل یا الگوئی که ممکن است بنا کد توجه نماید.

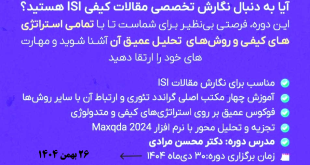

قابل توجه عزیزان که دوره های کاربردی داده کاوی در آکادمی تحلیل آماری ایران برگزار می شود.

محسن مرادی

مدرسه بین المللی پژوهش کمی و کیفی اولین و بزرگترین مرکز بین المللی برگزارکننده دوره های روش پژوهش و نرم افزارهای پژوهش کمی، کیفی، آمیخته و مروری در ایران

مدرسه بین المللی پژوهش کمی و کیفی اولین و بزرگترین مرکز بین المللی برگزارکننده دوره های روش پژوهش و نرم افزارهای پژوهش کمی، کیفی، آمیخته و مروری در ایران